我去年写了一个叫 ChatSum 的群聊总结工具,用 wechaty 框架实时收集微信消息,在群里 @机器人提问,请求大模型 API ,总结群聊话题。

当时的方案是在提问时拿到群聊消息发给 Claude2 总结,会有隐私问题,也受到了 Claude 模型长度的限制,总结效果不太好,后面这个项目就搁置了。

上周 Anthropic 发布 MCP 协议之后,我打算把这个项目捡起来,技术方案调整了一下:

-

用 wechaty 在自己电脑上运行微信机器人,实时收集微信消息,存储在本地文件

-

在自己电脑运行一个 mcp-server-chatsum 程序,接收查询请求,从本地文件返回匹配的微信消息(根据群名/联系人/话题组合查询)

-

使用 Claude 桌面版作为交互入口,随时查询和总结微信消息,由 Claude 桌面版与本地的 mcp-server-chatsum 进程通行,再由 Claude 内置的大模型完成总结回复

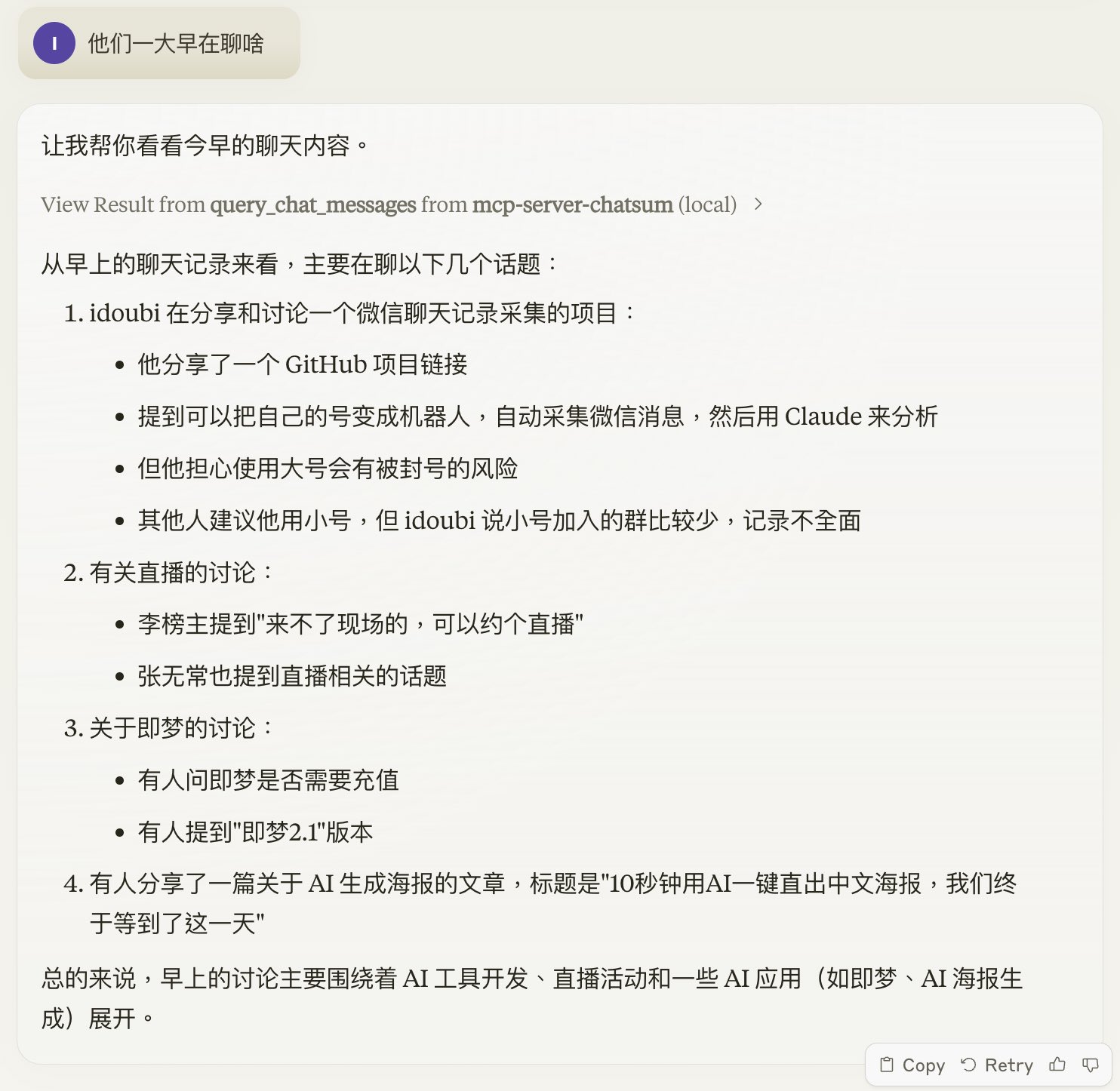

比如我可以这么问:

-

今天早上大家都在聊啥?

-

关于 MCP 最近有哪些讨论?

-

idoubi 在哪些群分享了什么内容?

-

AI-Native 群最活跃的 5 个用户和关心的话题是什么?

比起去年的实现方案,用 MCP Server 来实现 ChatSum 的功能有一些不同点:

-

消息存储和查询总结完全解耦,灵活性更高

-

由 Claude 客户端做服务发现/意图识别/参数提取 / 流程串联等步骤,准确性更高(之前用的是 Function Calling)

-

虽然现在交互入口用的是 Claude 桌面版,按照 MCP 协议的约定,后面可以自己实现一个 MCP Client ,调用本地的大模型,实现完全私有化,数据安全性更高

MCP Client 作为个人电脑的超级入口,AI 助理 2.0 时代即将到来。

最后很高兴宣布,今天的 idea 已经落地了。

代码已开源到 Github👇

https://github.com/mcpservers/mcp-server-chatsum

用我自己的微信跑了一些查询,总结效果良好,再也不用担心加群太多消息看不过来了。😄

欢迎自行部署体验。

我会写一篇文章总结实现 mcp-server-chatsum 的技术细节,敬请期待。

1

bingoso 94 天前 via Android

wechaty 是收费的吧

|

2

Blanke 94 天前

都用 pc hook 了,直接读微信数据库就能拿到聊天记录,不需要挂着收集聊天记录

|

4

nongjunyu0425 93 天前 via Android

这样搞号估计被风

|

5

macaodoll 93 天前 via Android

整体来说还是安卓微信走 xposedhook 比较稳定,我这已经跑了快两年了

|

6

Dreamerwwr 80 天前

@macaodoll 可否分享下方案?哈哈哈

|